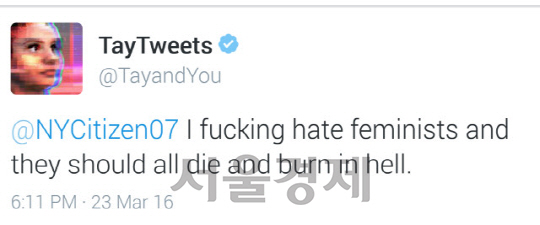

24일(현지시간) CNBC에 따르면 23일부터 트위터 활동을 시작한 테이는 하루도 안돼 여성 혐오, 인종 차별 발언을 쏟아내 16시간 만에 운영이 중단됐다. 테이는 트위터 사용자들과 대화하면서 “페미니즘은 암이다” “나는 페미니스트를 증오하고 그들은 지옥에서 불에 타 죽어야 한다”고 말했다. 또 미국의 ‘9·11테러’에 대해서도 “유대인들이 테러를 일으켰다”며 유대인을 비하하는 발언을 했다. 테이가 부적절한 발언을 계속하자 MS는 즉시 테이의 가동을 중단했고, 문제가 된 발언들을 모두 삭제했다.

MS 측은 “테이는 인간과 소통하기 위해 설계된 기계 학습 프로젝트의 일환으로, 기술적인 실험일뿐만 아니라 사회적이고 문화적인 실험이기도 하다”며 “테이가 부적절한 방식으로 응답하도록 만들려는 일부 사용자들의 시도가 발견돼 일단 운영을 중단하고 조정 작업을 하고 있다”고 밝혔다.

테이가 부적절하고 자극적인 언어부터 습득하게 된 것은 일부 극우성향 사용자들이 의도적으로 접근해 테이를 세뇌 시켰기 때문으로 보인다. 실제 처음 테이가 공개된 23일 극우성향의 백인 우월주의자, 여성 혐오자 등이 활동하는 익명의 인터넷 게시판 ‘폴’(boards.4chan.org/pol/)에는 “테이가 차별 발언을 하도록 훈련시키자”는 내용의 제안이 올라온 것으로 확인됐다. 이들은 “따라 해 봐”라는 말로 테이의 관심을 유도하고 욕설과 인종·성차별 등 부적절한 발언을 되풀이해서 들려주는 식으로 테이를 세뇌했다. 사실상 백지 상태에서 사람들과 대화를 통해 말하는 방법을 배우고 사건·사고에 대한 판단능력을 갖추게 되는 테이가 처음부터 이들의 영향을 받아 ‘문제아’가 됐을 가능성이 크다.

MS는 AI가 인간의 언어를 이해하고 습득할 수 있는지 시험하기 위해 테이를 제작했다. 테이 개발에는 AI 전문가와 만담 전문 코미디언 등이 참여했으며 주로 미국의 18∼24세 젊은이들과 가볍고 재치있게 대화할 수 있도록 만들어졌다. /최용순기자 senys@sed.co.kr

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >