“인간 지능에 대한 호기심이 인공지능(AI)개발의 가장 핵심적인 원동력입니다”

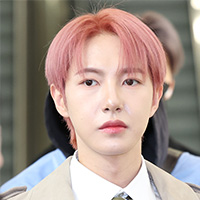

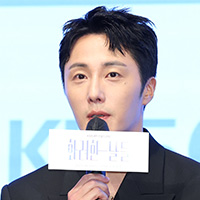

AI분야 권위자인 최재식(사진) KAIST AI대학원 교수는 11일 ‘2020 가을 카오스강연’시리즈의 여섯번째 연사로 나서기 전 최근 카오스재단과 가진 인터뷰에서 “AI전문가를 꿈꾸는 학생이라면 수학이나 프로그래밍을 잘 하는 것에 앞서 ‘사람의 지능적 행동’을 어떻게 구현해 볼 수 있을까‘라는 호기심을 갖고 직접 도전해보는 게 가장 중요하다”고 조언했다.

이번 ‘AI의 사고과정을 설명할수 있을까’라는 주제로 강연하는 최 교수는 차세대 AI기술로 불리는 ‘설명가능AI(XAI)’분야의 선두주자다. 기존 AI시스템은 주어진 자료를 분석·예측할 수 있지만 그 결과가 도출되는 원인을 알기 어려운 단점이 있는데, 설명가능AI 은 그런 결과에 대한 핵심 원인을 파악할 수 있는 시스템이다.

현재 KAIST 설명가능AI연구센터장을 맡고 있는 그는 “최근 딥러닝과 같이 사람의 뇌를 모사한 AI 시스템은 용량이 커 내부의 의사결정을 다 알 수 없는 경우가 있다”며 “AI가 잘못되거나 불완전한 의사결정을 내릴 수도 있는데 이 같은 불완전한 면을 설명가능AI가 보완할 수 있다”고 말했다.

그는 설명가능AI가 사람 생명, 안전과 재산에 직결되는 중대한 부문·환경의 ‘근간 시스템(미션 크리티컬)’이 된다고 규정했다. 그는 “의료 시스템이나 자율자동차 주행처럼 생명과 연관된 사항에 대해 의사결정이 어떻게 이뤄지는지 반드시 알아야 한다”며 “AI 적용을 검증하는 시스템인 셈”이라고 말했다.

최 교수의 설명가능AI 연구는 실제 상용화를 통해 산업현장에서도 성과를 내고 있다. 포스코 포항제철소 2고로가 대표적 사례다. 2고로는 딥러닝 모델을 적용해 고로 통기성·연소성·용선온도 등을 스스로 제어하는 등 자동화를 90% 수준까지 끌어올렸다. 여기에 설명가능AI 기술을 적용해 이 같은 제어행동의 이유를 파악하고 이를 통해 철강제품의 품질과 생산성 향상을 높이는 연구를 진행하고 있다.

그는 “가령 AI에 들어가는 입력값 중에 특정한 입력이 들어오면 AI 판단이 불완전하게 되는데 이 같은 입력값이 무엇인지도 가려낸다”며 “다양한 분야로 상용화가 가능한 기술”이라고 설명했다.

미국 일리노이대에서 전산학 박사를 딴 최 교수는 로런스버클리연구소에서 연구원으로 근무했으며 지난 2013년부터 울산과학기술원(UNIST) 전기컴퓨터공학부 교수로 인공지능연구센터장을 맡다가 지난해 KAIST로 자리를 옮겼다. 병역특례업체에 근무할 당시 네트워크 패턴을 분석하면서 알고리즘을 이용해 자동으로 파악하는 방법을 고민한 것이 그를 AI 과학자의 길로 이끌었다.

그는 “어떤 경우에 사람은 어떻게 판단할까를 생각하다가 로봇에 흥미를 느꼈고 이것이 AI 연구를 시작하는 계기가 됐다”며 “자신이 스스로 고민과 호기심을 해결해내는 학생들이 늘어나면 우리나라 AI 연구의 미래도 밝을 것”이라고 덧붙였다.

/박현욱기자 hwpark@sedaily.com

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >