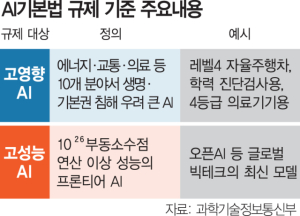

운전자 개입 없이 스스로 작동하는 완전 자율주행 기술이 국내 인공지능(AI) 기업에게 사고 책임을 묻는 중점 규제 대상으로 지정됐다. 정부는 이를 포함해 에너지·교육·의료 등 AI의 파급효과가 큰 10개 분야 규제 기준을 구체화해 산업 육성에 필요한 기술 안전성 확보에 나설 방침이다.

과학기술정보통신부는 17일 서울 중구 상연재 별관에서 ‘AI 발전과 신뢰 기반 조성 등에 관한 기본법(AI기본법)’ 하위법령 제정방향 관련 설명회를 열고 ‘고영향 AI 판단 가이드라인’을 포함한 AI기본법 하위법령 초안을 공개했다. 과기정통부는 내년 1월 AI기본법 시행을 앞두고 하위법령을 준비 중이다. 특히 법적으로 안전성 관리 의무와 과태료 부과 책임 등이 주어지는 규제 대상이자 업계 주된 관심사인 고영향 AI 판단 가이드라인이 처음으로 공개됐다.

우선 자율주행차는 운전자가 개입하는 현재 기술 수준인 레벨3은 해당되지 않지만 장차 보급될 레벨4부터는 고영향 AI로 취급된다. 교육 현장에서 기초학력 진단검사, 생활기록부 작성 등 평가 관련 업무에 교사가 개입하지 않는다면 고영향 AI가 된다. 인공심폐장치나 인공혈관처럼 환자에 미치는 영향이 큰 의료기기법상 4등급 기기에 적용된 AI, 원전 사고 예방에 필수적인 원자력 ‘안전등급’ 시설에 적용된 AI도 마찬가지다.

이를 포함해 에너지, 먹는물, 보건의료, 의료기기, 원자력, 범죄 수사·체포, 채용·대출심사, 교통, 공공서비스, 교육 등 생명이나 기본권에 위험을 초래할 수 있는 10개 분야의 AI 개발사나 이용 사업자는 가이드라인에 따라 자사 기술이 고영향 AI에 해당하는지 사전에 확인하고 사고 예방과 대응, 이용자 보호 대책 등을 담은 위험관리방안을 수립해야 한다. 위반 시 과태료 최대 3000만 원 부과와 시정조치 등 제재가 가해진다.

이와 별개로 아직 안전성이 완전히 확인되지 않은 글로벌 최신 AI 모델인 프론티어 모델은 ‘고성능 AI’로서 더 강한 규제를 받는다. 해당 사업자는 기술은 물론 인권, 개인정보 보호, 윤리, 사이버보안 등 다학제적 전문인력으로 위험평가조직(RAT)을 꾸리고 자사 기술의 심각성·중대성·실현 가능성·빈도·관리 가능성을 평가해 관리 대책을 매년 과기정통부에 보고해야 한다. 그외에도 파인튜닝(미세조정) 등 AI 모델 변경으로 위험이 증가한 경우 한달, 사고 발생 시 일주일 내 별도 보고해야 한다. 다만 현재 국산 모델 대부분은 고성능 AI에 해당하지 않아 GPT 같은 글로벌 빅테크 모델에 대한 규제가 될 전망이다.

매출 1조 원 이상 해외 기업은 국내 대리인 지정 의무도 생긴다. 딥페이크 같은 AI 생성물은 워터마크를 달아야 한다. 국방·안보용 AI는 AI기본법 규제가 면제된다. 사업자들이 규제에 대비할 수 있도록 1년 이상 과태료 계도기간이 운영된다. 김경만 과기정통부 AI기반정책관은 “가급적 느슨한 규제 체계로 산업 진흥에 중점을 뒀다”며 “의견수렴을 통해 내년 1월 법을 시행할 계획”이라고 말했다.

업계 관계자는 “새로운 아이디어로 사업화하려는 벤처·스타트업에게 규제가 특히 민감하다”며 “실제 현장에서 예기치 못한 독소조항이 있을 수 있는 만큼 충분한 검토가 필요하다”고 했다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

sookim@sedaily.com

sookim@sedaily.com