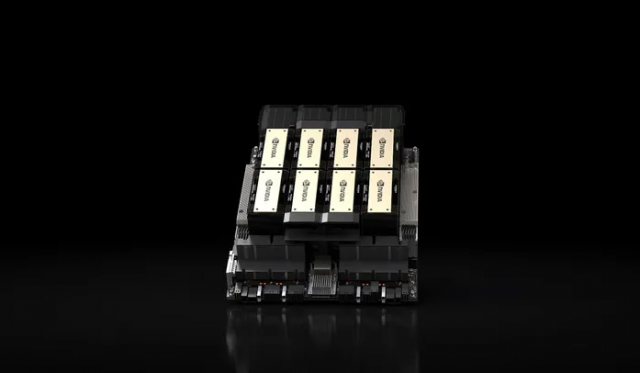

엔비디아가 인공지능(AI) 모델의 핵심 컴퓨팅 자원으로 떠오른 ‘H100’을 뛰어 넘는 새로운 제품을 내놓으면서 AI칩 최강자로서 수성에 나선다. 기업들이 품귀를 겪고 있는 H100을 업그레이드하면서 엔비디아의 수익성 또한 한층 개선될 것이라는 평가가 나오고 있다.

13일(현지 시간) 엔비디아는 기존에 오픈AI의 ‘GPT-4’ 모델 등을 훈련하는 데 쓰인 AI 가속기 H100 대비 성능을 한층 업그레이드 한 ‘H200’을 출시했다.

H200은 엔비디아 최초로 141기가바이트(GB)에 달하는 ‘차세대 고대역폭메모리(HBM)3’를 탑재해 성능을 대폭 끌어올렸다. 초당 4.8테라바이트(TB)의 속도 구현이 가능해 H100(초당 3.35TB)를 크게 뛰어 넘었다. 메모리 용량도 H100 대비 76% 늘어났다. 최근에는 H200을 활용해 메타의 대규모 언어모델인 ‘라마(Llama)2’를 훈련한 결과 추론 성능이 두 배 가까이 높아졌다는 설명이다. 이안 벅 엔비디아 고성능 컴퓨팅 제품 담당 부사장은 “더 빠르고 강력한 HBM 메모리와의 결합은 생성형 AI 활용을 요구하는 모든 작업 성능을 비약적으로 끌어 올렸다”고 강조했다.

H200이 출시되면 올 4분기 출시 예정인 AMD의 ‘MI300X’와 경쟁을 펼치게 될 전망이다. 엔비디아는 AI칩 분야 최강자로서 갖고 있는 확고한 우위를 이어가기 위해 절치부심한 것으로 보인다. 디온 해리스 엔비디아 데이터센터 총괄은 “지금 시장에서 벌어지는 경향을 보면 모델 규모가 빠르게 커지고 있다”며 “최신의 고도화된 기술을 신속하게 도입하는 이유”라고 강조했다.

특히 H100 제품과 호환이 가능해 기존 회사들이 H200을 활용하려고 해도 별도의 인프라를 구축하지 않고도 가동이 가능하다. 경쟁적으로 AI 회사들이 H100 사재기를 하는 가운데 내년 2분기 H200이 출하되면 H100의 품귀 현상도 일부 해소하면서 기업의 컴퓨팅 인프라 업그레이드를 촉진할 것으로 보인다. 샘 올트만 오픈AI 최고경영자(CEO)도 전날 파이낸셜타임즈와의 인터뷰를 통해 “H100 수급난이 내년 중 해소될 것”이라고 전망한 바 있다.

엔비디아의 H100은 가격대가 최대 4만 달러 수준으로 형성돼 있다. H200의 가격은 이를 웃돌 것으로 전망되면서 수익성 또한 한층 개선될 것으로 보인다. 미 경제방송 CNBC에서 ‘매드 머니’를 진행하는 짐 크레이머는 “많은 투자자들이 손 꼽아 기다려왔던 일”이라며 “이번 H200 출시 소식으로 엔비디아의 주가가 또 한 차례 부스팅 효과를 겪을 것”이라고 강조했다. 엔비디아의 주가는 올 들어 240% 가량 오른 바 있다.

다만 여전히 중국 시장은 수출 통제 문제가 남아 있다. 조 바이든 행정부가 사실상 중국에 모든 엔비디아 칩 수출을 통제하면서 고사양 AI칩은 수출 길이 막혔다는 평가다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

madein@sedaily.com

madein@sedaily.com