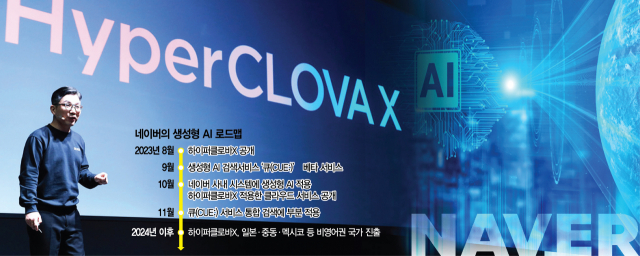

네이버가 24일 생성형 인공지능(AI) 서비스를 위한 거대언어모델(LLM)인 ‘하이퍼클로바X’ 출시와 함께 글로벌 AI 시장 공략 로드맵 마련에도 착수한다. 하이퍼클로바X는 네이버가 2021년 5월 공개한 ‘하이퍼클로바’의 업그레이드 버전으로 국내에서는 오픈AI가 선보인 ‘챗GPT’의 대항마로 꼽힌다.

네이버는 하이퍼클로바X 출시로 국내 AI 시장 수성은 물론 10월 출범 예정인 관계사 ‘라인야후’와의 협업을 기반으로 일본 AI 시장에서도 성과를 낸다는 방침이다. 네이버는 향후 비영어권 국가이자 자국 데이터 주권 확보에 관심이 많은 스페인·멕시코는 물론 아랍어를 쓰는 중동 국가로까지 AI 영토를 확장한다는 방침이다.

20일 정보기술(IT) 업계에 따르면 네이버는 자사 AI의 강점으로 ‘한국어에 최적화된 서비스’를 내세우고 있다. 실제 하이퍼클로바X는 챗GPT 대비 한국어를 6500배 이상 학습했다.

특히 한국어 중심의 초거대 AI는 한국어에 최적화된 ‘토큰(token)’을 배정하게 돼 있어 상대적으로 저렴한 가격에 챗봇 서비스 제공이 가능하다. 토큰은 인공지능 학습용으로 모아 둔 일종의 ‘말뭉치’로 문장을 만들어내는 데 사용되는 토큰이 많아질수록 생성형AI의 연산 과정 및 시간도 길어질 수밖에 없는 구조다. 반면 특정 언어에 최적화된 LLM은 그만큼 짧은 연산 과정을 거쳐 답변을 내놓기 때문에 답변 산출 비용이 영어 기반 LLM 대비 낮다. 예를 들어 ‘놀이터에 놀러 가고 싶어’라는 한국어 문장의 경우 챗GPT는 30개의 토큰으로 분류한다. ‘놀’이라는 글자 하나를 놓고 보면 ‘ㄴ’ ‘ㅗ’ ‘ㄹ’이라는 자음 및 모음 각각을 토큰으로 분류해 총 3개의 토큰을 할당하는 구조이기 때문이다. 이 같은 방식으로 ‘놀이터에 놀러 가고 싶어’라는 문장에는 총 30개의 토큰이 사용된다.

반면 챗GPT는 ‘놀이터에 놀러 가고 싶어’와 같은 뜻의 영어 문장인 ‘I want to go to the playground’에는 8개라는 훨씬 적은 수의 토큰만 할당한다. 챗GPT가 같은 뜻의 문장을 작성하더라도 한국어 문장 생성에 드는 비용이 영어 문장 대비 높을 수밖에 없는 구조다. 네이버는 하이퍼클로바X가 생성하는 한국어 문장을 띄어쓰기·음절·형태소 등을 기준으로 토큰화할 예정이라 챗GPT 대비 3분의 1 수준의 토큰으로 한국어 문장 생성이 가능할 것으로 전망된다.

특히 LLM에 자사 서비스를 ‘플러그인’ 형태로 연결시켜 신규 서비스를 내놓으려는 기업들 입장에서는 한국어에 최적화된 네이버의 LLM 사용 시 상당한 비용 절감 효과를 거둘 수 있을 것으로 보인다. 네이버가 24일 하이퍼클로바X 공개 무대에서 유료화 로드맵 설명에 상당 시간을 할애하는 이유다. 네이버는 향후 자사 LLM에 스페인어·아랍어·일본어를 대규모로 학습할 경우 이들 국가의 AI 시장 장악까지 가능할 것으로 보고 있다.

물론 네이버의 하이퍼클로바X는 빅테크 대비 약점도 많다. 성낙호 네이버클라우드 하이퍼스케일 AI 기술총괄은 석 달 전 한 외신과의 인터뷰에서 “기술적 관점에서 우리(네이버)의 기술은 오픈AI의 챗GPT 대비 8개월가량 뒤처져 있다”며 기술 격차를 인정한 바 있다.

자금력 측면에서도 네이버는 빅테크 대비 크게 불리하다. 네이버의 올 상반기 별도 기준 현금 및 현금성 자산은 5848억 원으로 2021년 말의 9644억 원 대비 사실상 반토막 났다. 네이버가 최근 2년간 해외 시장 공략을 위해 중고 거래 및 콘텐츠 기업 인수합병에 힘을 쏟으며 자금 여력이 크게 줄어든 탓이다. 특히 네이버의 현금 및 현금성 자산 보유액은 오픈AI가 지난해 기록한 손실 규모 5억 4000만 달러(약 7236억 원)에도 못 미친다.

하이퍼클로바X 공개 후 적절한 수익 모델을 찾지 못한 채 이용자 수만 빠르게 늘어날 경우 네이버의 보유 현금이 불과 몇 년 만에 바닥날 수 있는 셈이다. 이 때문에 네이버는 최근 판교테크원타워 보유 지분 45.08%를 싱가포르투자청(GIC)에 3500억 원에 매각한 것으로 전해지는 등 자금 확보에 분주한 모습이다.

AI용 데이터센터 업그레이드에 천문학적 비용을 쏟아부어야 한다는 점도 네이버에 불리한 부분이다. LLM 인프라 구축에는 빅데이터 학습에 최적화된 엔비디아의 그래픽처리장치(GPU)가 탑재돼야 하지만 GPU 수요 폭증으로 글로벌 빅테크들 또한 수급에 어려움을 겪고 있다. 이 때문에 엔비디아 GPU ‘H100’ 가격은 지난해 3만 6000달러 수준이었지만 올 상반기 4만 6000달러까지 치솟았으며 하반기에도 가격 상승세가 이어지고 있다. AI 추론용 칩에는 엔비디아 제품 외에 리벨리온·사피온·퓨리오사AI 등 한국 기업의 AI 칩을 사용해도 되지만 학습용 칩은 엔비디아 GPU 외에는 대안이 없다는 점에서 자금력이 부족한 네이버 입장에서 좋지 않은 상황이다. 한 IT 업체 관계자는 “카카오·엔씨소프트·LG 등이 글로벌 빅테크의 LLM을 사용하는 대신 자체 LLM을 개발하고 있는 것은 그만큼 기술 종속을 우려하고 있다는 방증”이라며 “특히 네이버가 빅테크와의 격전이 불가피한 범용 LLM을 내놓는다는 점에서 네이버의 성과에 따라 국내 AI 산업 생태계의 방향 또한 크게 좌우될 것”이라고 밝혔다.

< 저작권자 ⓒ 서울경제, 무단 전재 및 재배포 금지 >

chopin@sedaily.com

chopin@sedaily.com